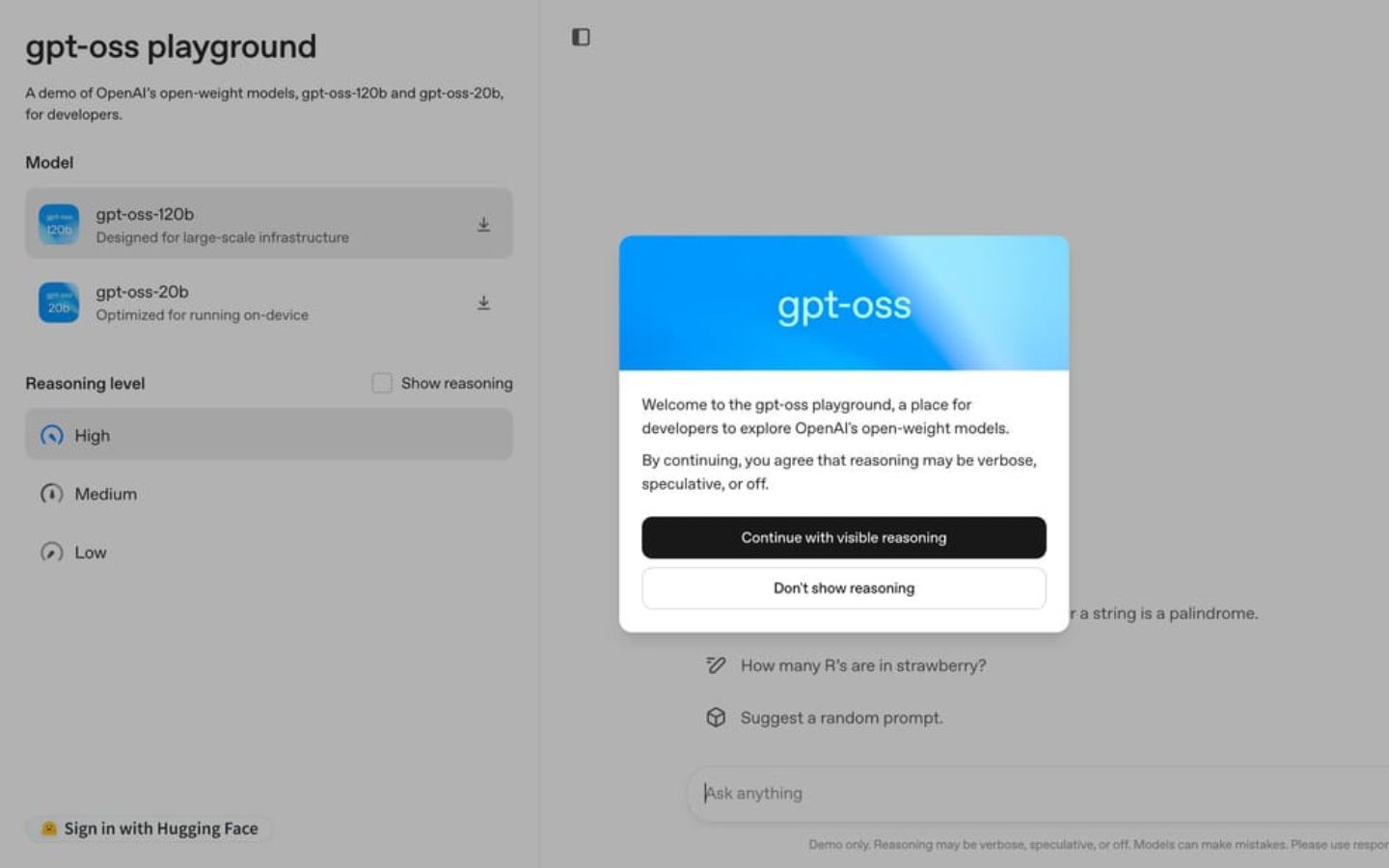

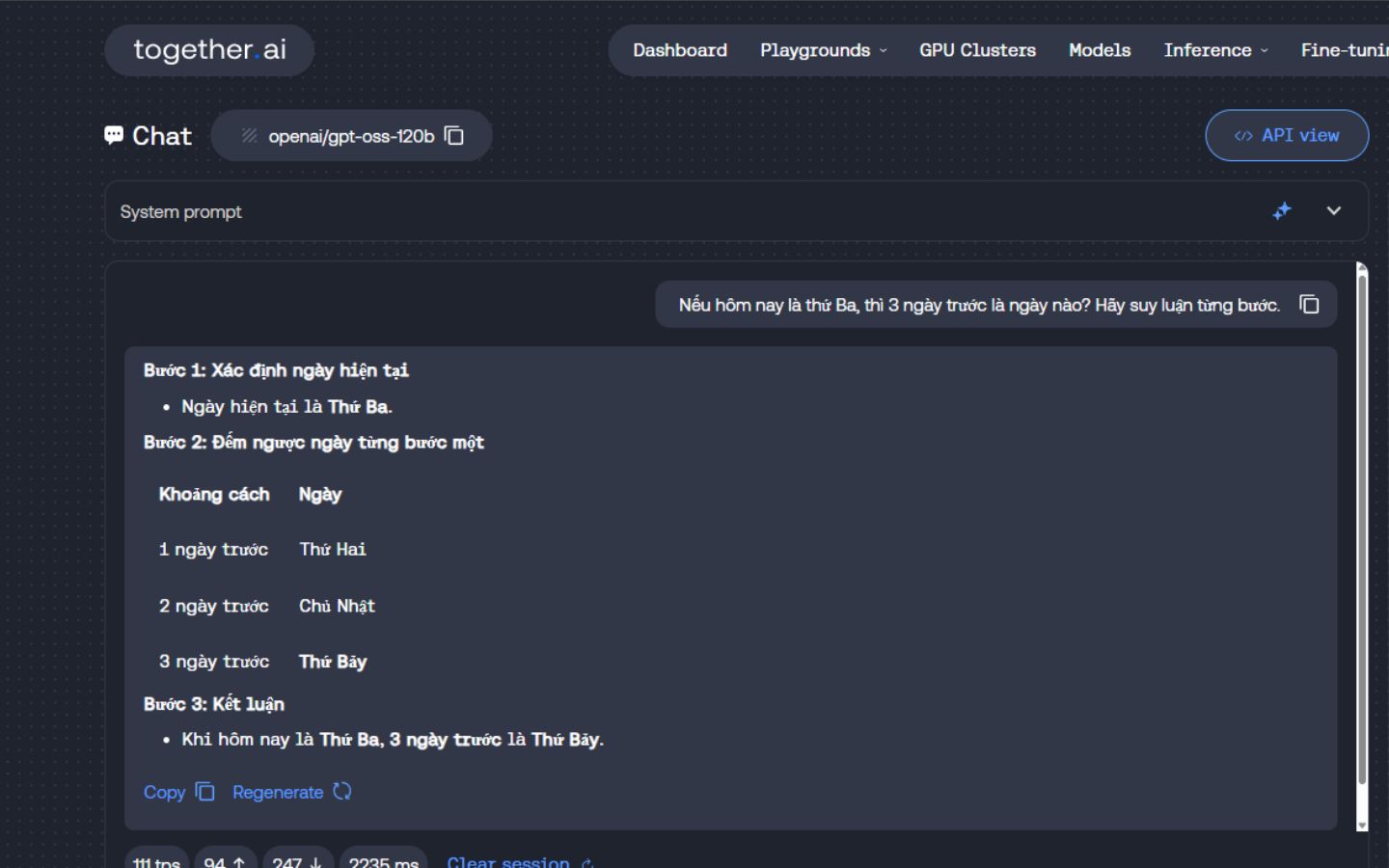

Bạn muốn trò chuyện với mô hình trí tuệ nhân tạo AI giống ChatGPT nhưng chạy hoàn toàn trên máy tính của bạn, không cần internet hay phụ thuộc vào OpenAI? Tin vui là bạn hoàn toàn có thể làm được điều đó với GPT OSS, dòng mô hình mã nguồn mở do OpenAI phát hành. Trong bài viết này, Phong Vũ Tech News sẽ hướng dẫn bạn từng bước thiết lập và sử dụng GPT OSS 20B và 120B ngay trên máy tính bằng những công cụ dễ dùng như Ollama và Transformers. Cùng tham khảo ngay!

I. GPT OSS là gì?

GPT OSS là tên viết tắt của “GPT Open Source Series” – một dòng mô hình ngôn ngữ giống ChatGPT nhưng được phát hành dưới dạng mã nguồn mở. Bạn có thể tải về và chạy trực tiếp trên máy của mình (chẳng hạn như laptop xách tay) mà không cần gọi đến máy chủ OpenAI. GPT-OSS có hai phiên bản chính với yêu cầu phần cứng khác nhau, cụ thể:

| Mô hình | GPT OSS 20B | GPT OSS 120B |

| Dung lượng | ~20 tỷ tham số | ~120 tỷ tham số |

| VRAM cần thiết | ≥16GB | ≥60GB hoặc nhiều GPU |

| Phù hợp | Máy tính có card đồ họa mạnh như RTX 3090/4090 hoặc Mac M2/M3 | Máy trạm, máy chủ chuyên dụng |

Lưu ý: Hai mô hình này được nén lại theo định dạng MXFP4 để tiết kiệm bộ nhớ, nhưng chỉ hoạt động tốt với các dòng card đồ họa đời mới như RTX 50xx hoặc NVIDIA H100.

II. Thiết lập nhanh chóng với Ollama: Lựa chọn đơn giản nhất

Nếu bạn muốn một cách nhanh gọn lẹ, không cần phải đau đầu với code và các thư viện phức tạp, Ollama chính là giải pháp dành cho bạn. Ollama là một nền tảng tuyệt vời giúp bạn chạy các LLM mã nguồn mở một cách dễ dàng.

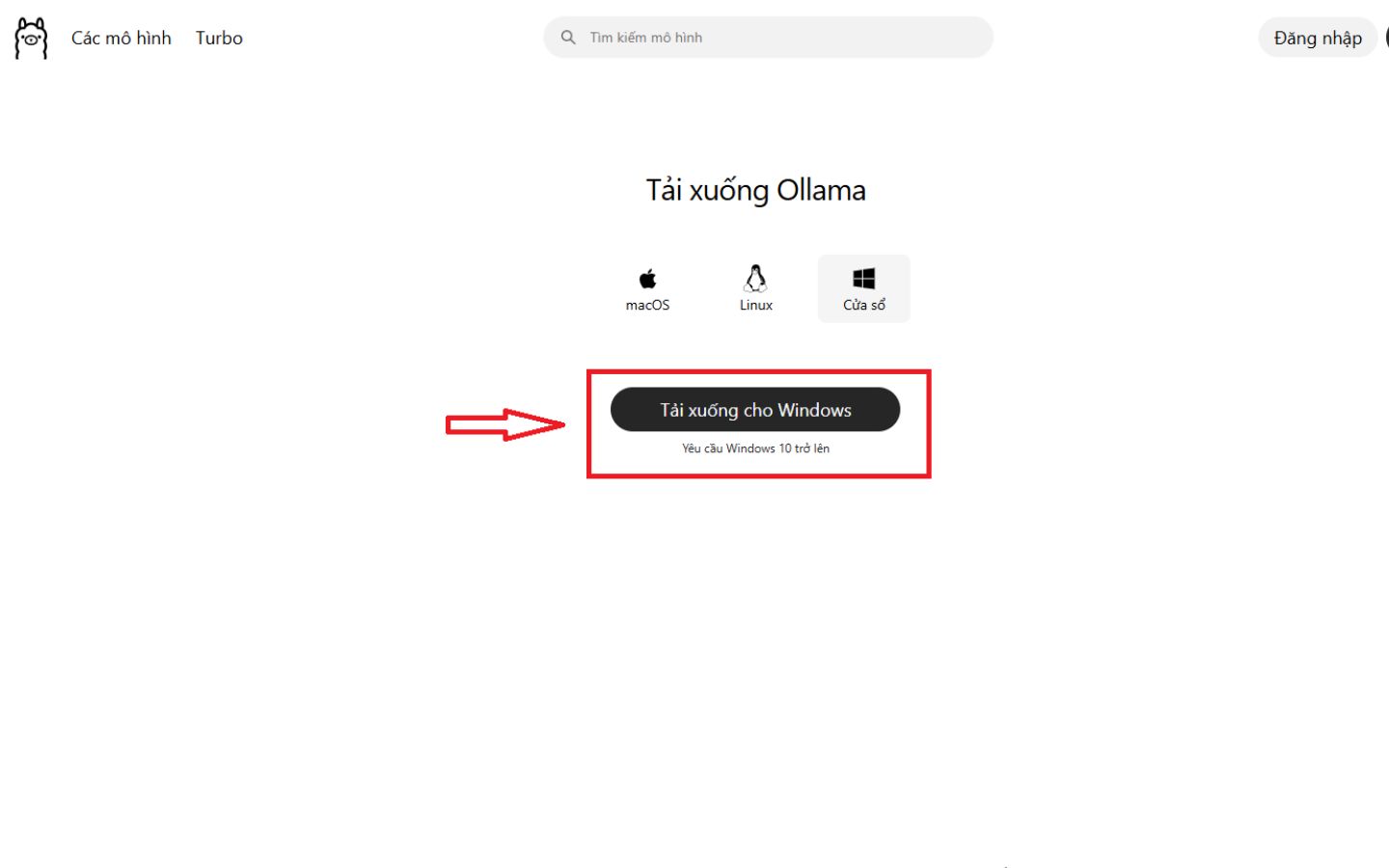

Bước 1: Cài đặt Ollama: Truy cập trang chủ của Ollama theo đường link: https://ollama.com/download để tải về và cài đặt. Ollama hỗ trợ cả Windows, macOS và Linux.

Bước 2: Kéo mô hình về máy: Sau khi cài đặt xong, bạn mở Terminal (trên macOS/Linux) hoặc Command Prompt/PowerShell (trên Windows) và chạy lệnh sau để tải mô hình về:

- Với mô hình 20B chạy lệnh: ollama pull gpt-oss:20b

- Với mô hình 120B chạy lệnh: ollama pull gpt-oss:120b

Trong quá trình tải, hãy kiên nhẫn một chút vì dung lượng của các mô hình này khá lớn nên thời gian thực hiện sẽ mất khoảng vài phút. Sau khi tải xong, mô hình sẽ được lưu trữ cục bộ trên máy tính của bạn.

Bước 3: Trò chuyện ngoại tuyến: Sau khi thành công tải mô hình về thiết bị, giờ đây bạn đã có thể trò chuyện với mô hình mà không cần kết nối internet. Chỉ cần chạy lệnh sau:

ollama run gpt-oss:20b

Tiếp đó, Ollama sẽ tự động áp dụng các mẫu trò chuyện, cho phép bạn tương tác trực tiếp qua cửa sổ dòng lệnh.

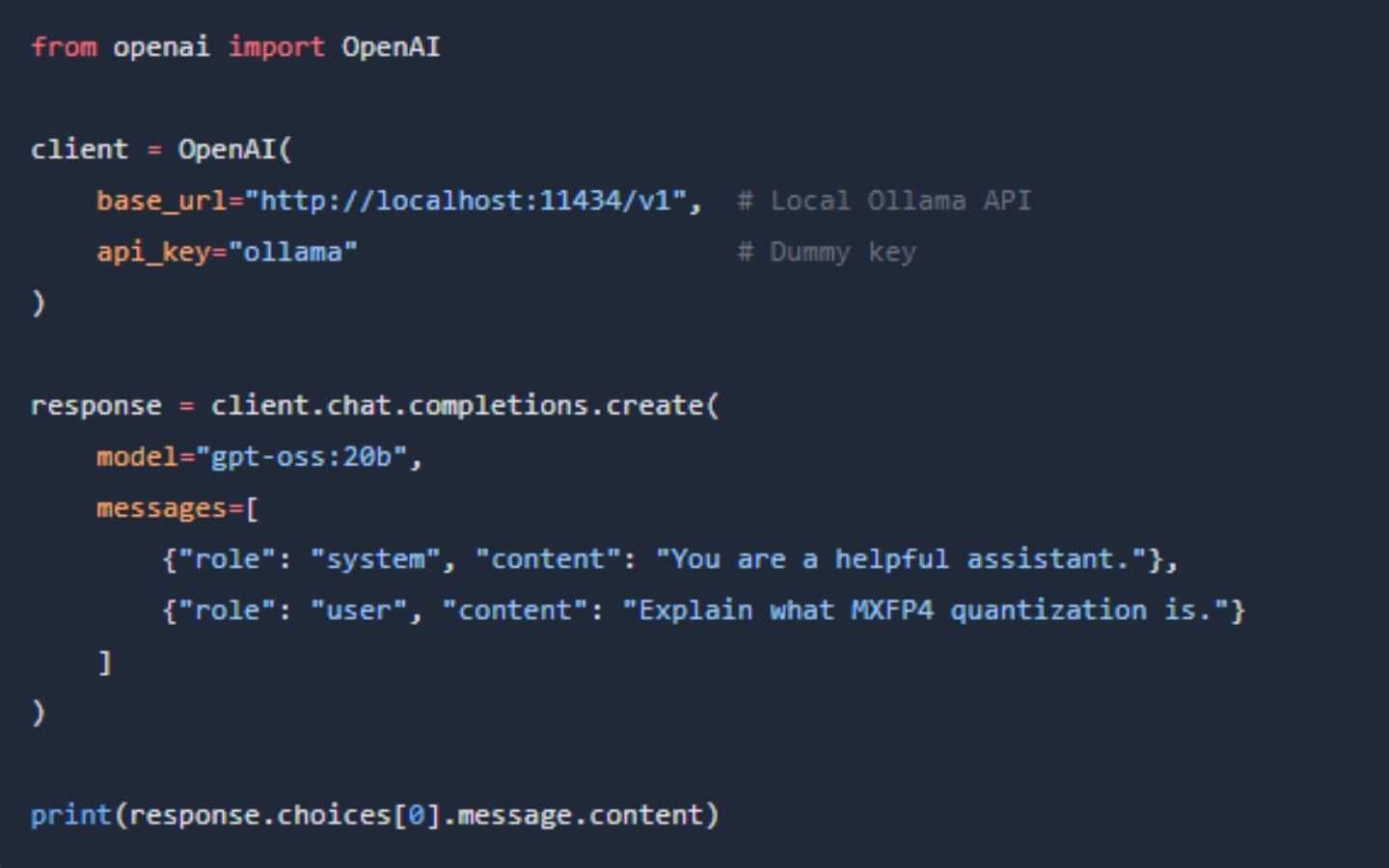

Bước 4: Tận dụng API: Điều thú vị là Ollama cung cấp một API tương thích với API của OpenAI. Điều này có nghĩa là bạn có thể sử dụng các thư viện và code đã quen thuộc mà không cần thay đổi nhiều. Dưới đây là một ví dụ bằng Python:

Bạn có thể thấy, đoạn code này gần như giống hệt với cách sử dụng API của OpenAI. Điều này giúp bạn dễ dàng tích hợp GPT-OSS vào các ứng dụng hiện có của mình.

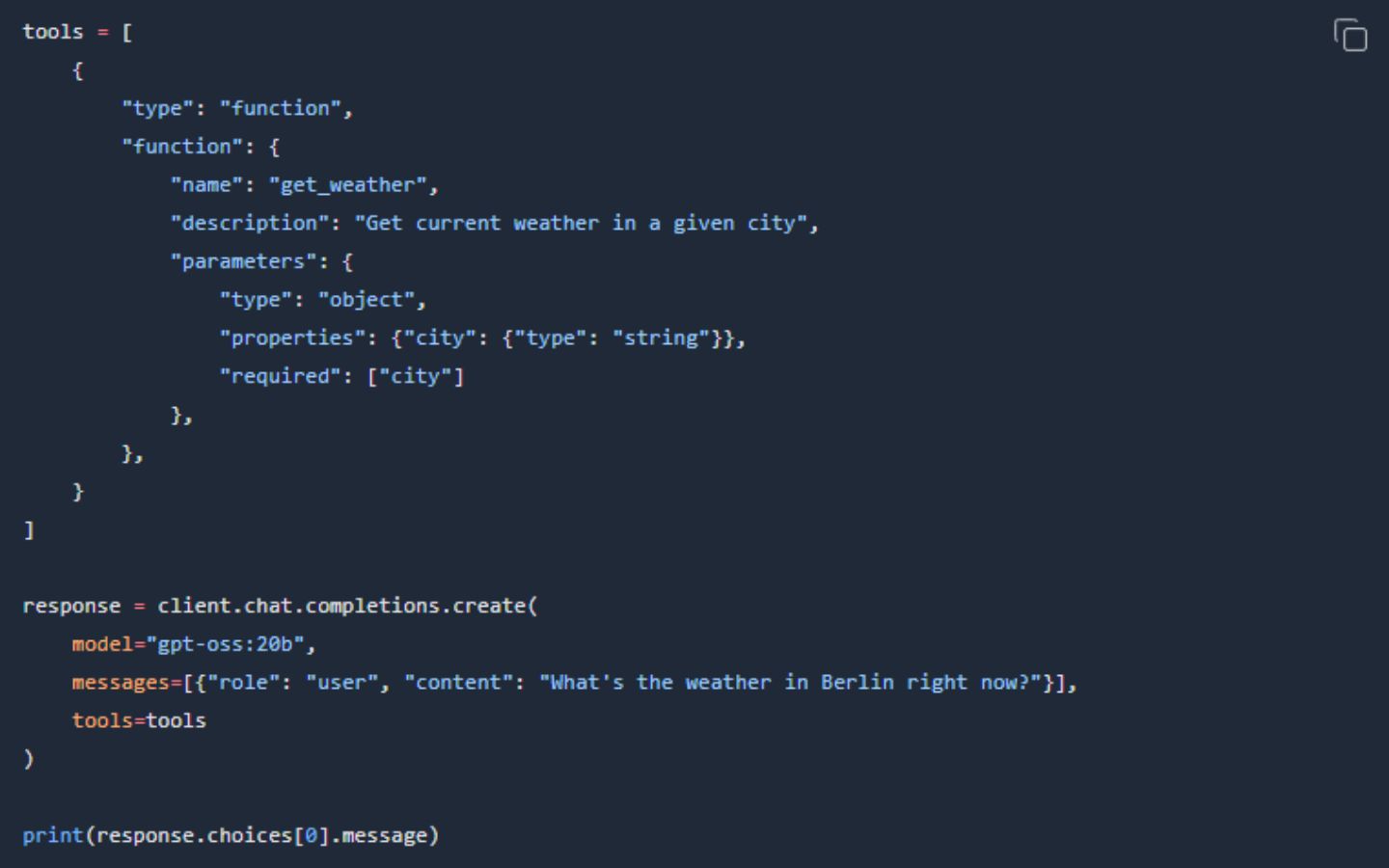

Bước 5: Sử dụng công cụ (Function Calling): Một tính năng mạnh mẽ khác của GPT-OSS là khả năng gọi hàm (function calling). Ollama cũng hỗ trợ điều này. Ví dụ, bạn có thể tạo một công cụ để lấy thông tin thời tiết và mô hình sẽ biết cách sử dụng nó khi bạn hỏi về thời tiết của một thành phố.

Mô hình sẽ không tự trả lời mà sẽ đưa ra một “lệnh” để gọi hàm get_weather với tham số là Berlin. Bạn chỉ cần thực thi lệnh đó và đưa kết quả trở lại cho mô hình để nó đưa ra câu trả lời cuối cùng.

III. Thiết lập nâng cao với thư viện Hugging Face Transformers

Nếu bạn là một lập trình viên hoặc muốn có toàn quyền kiểm soát, việc sử dụng trực tiếp các thư viện như Hugging Face Transformers là lựa chọn tốt nhất. Các bước thực hiện cụ thể như sau:

Bước 1: Chuẩn bị môi trường Python

Để tránh xung đột thư viện, bạn nên tạo một môi trường Python ảo mới. Sau đó, cài đặt các gói cần thiết:

pip install -U transformers accelerate torch triton kernels

pip install git+https://github.com/triton-lang/triton.git@main#subdirectory=python/triton_kernels

Trong đó:

- transformers: Thư viện chính để làm việc với các mô hình LLM.

- accelerate: Giúp tự động hóa việc phân bổ mô hình trên nhiều GPU hoặc CPU.

- torch: Nền tảng Pytorch để tính toán tensor.

- triton kernels: Cần thiết cho việc tương thích với định dạng lượng tử hóa MXFP4.

Bước 2: Chạy máy chủ API

Bạn có thể biến máy tính của mình thành một máy chủ API nhỏ gọn chỉ bằng một lệnh đơn giản: transformers serve

Sau đó, bạn có thể tương tác với nó qua CLI hoặc gửi các yêu cầu HTTP.

- Với CLI: transformers chat localhost:8000 –model-name-or-path openai/gpt-oss-20b

- Với cURL: curl -X POST http://localhost:8000/v1/responses -H “Content-Type: application/json” -d ‘{“messages”: [{“role”: “system”, “content”: “hello”}], “temperature”: 0.9, “max_tokens”: 1000, “stream”: true, “model”: “openai/gpt-oss-20b”}’

Cách này rất tiện lợi nếu bạn muốn tích hợp mô hình vào các ứng dụng khác.

Bước 3: Suy luận nhanh với Pipeline

Cách đơn giản nhất để chạy mô hình GPT-OSS trong code Python là sử dụng pipeline của Transformers. Nó tự động xử lý mọi thứ từ tải mô hình, tokenizer cho đến quá trình tạo văn bản.

Bạn chỉ cần cung cấp các tin nhắn và mô hình sẽ tạo ra câu trả lời. Tham số device_map=”auto” sẽ giúp bạn tận dụng tối đa GPU của mình.

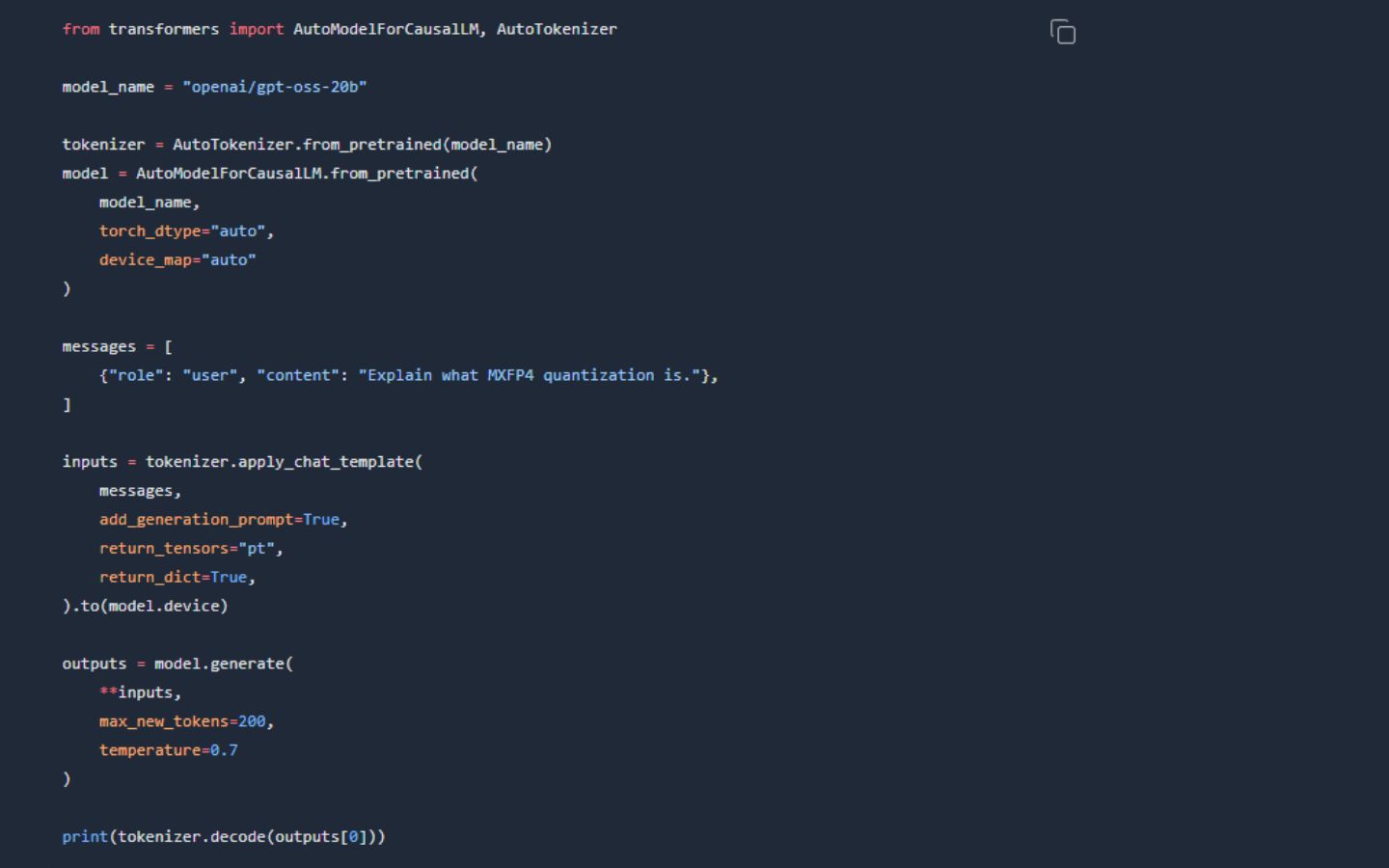

Bước 4: Suy luận nâng cao với .generate()

Nếu bạn cần kiểm soát chi tiết hơn, bạn có thể tải mô hình và tokenizer riêng, sau đó triển khai phương thức .generate() theo lệnh như sau:

Cách này cho phép bạn tùy chỉnh chi tiết các tham số của quá trình tạo văn bản như max_new_tokens, temperature, và nhiều hơn nữa.

Bước 5: Sử dụng mẫu trò chuyện và gọi công cụ

Các mô hình GPT-OSS của OpenAI sử dụng định dạng phản hồi có cấu trúc. Bạn có thể sử dụng mẫu trò chuyện tích hợp sẵn của Transformers hoặc thư viện openai-harmony để xây dựng các lời nhắc phức tạp hơn. Cụ thể:

- Với mẫu trò chuyện tích hợp: Bạn có thể định nghĩa các vai trò như system, user và assistant để hướng dẫn mô hình.

- Với thư viện openai-harmony: Đây là thư viện được OpenAI phát triển, cung cấp các cấu trúc dữ liệu và công cụ mạnh mẽ để xử lý các lời nhắc và phản hồi của mô hình. Tuy nhiên, nó yêu cầu cài đặt thêm và có thể phức tạp hơn một chút.

Bước 6: Suy luận đa GPU (chỉ dành cho mô hình 120B)

Đối với mô hình 120B, nếu bạn muốn chạy nó trên nhiều GPU, Transformers cung cấp các tùy chọn như tp_plan=”auto” để tự động phân chia mô hình. Bạn cũng có thể sử dụng accelerate launch hoặc torchrun để khởi chạy các thiết lập phân tán.

IV. Dùng GPT OSS với SDK của OpenAI Agents

Nếu bạn đang phát triển phần mềm AI dùng OpenAI Agents SDK (Python hoặc TypeScript), bạn có thể chuyển qua GPT OSS dễ dàng bằng cách:

- Dùng LiteLLM để tạo proxy cho mô hình GPT OSS

- Hoặc dùng Responses.js để tương thích định dạng API

V. Một số lưu ý về phần cứng khi chạy GPT OSS 20B và 120B trên máy tính

Trong quá trình chạy GPT OSS 20B và 120B, bạn cần đặc biệt lưu ý những vấn đề liên quan đến VRAM, cụ thể như sau:

| Mô hình | VRAM cần thiết | Phù hợp với |

| GPT OSS 20B | ≥16GB (MXFP4) | GPU tiêu dùng cao cấp hoặc Mac M2/M3 |

| GPT OSS 120B | ≥60GB (MXFP4) | Multi-GPU / H100 / máy trạm mạnh |

Lưu ý: Nếu thiếu VRAM, có thể chuyển sang CPU, nhưng tốc độ sẽ rất chậm.

VI. Tổng kết

Với GPT OSS 20B và 120B, bạn hoàn toàn có thể chạy mô hình AI giống ChatGPT ngay trên máy tính của mình mà không cần internet. Dù bạn là người dùng chuyên nghiệp hay cơ bản, việc cài đặt và sử dụng qua Ollama hoặc Transformers đều rất đơn giản. Chỉ cần máy đủ mạnh, bạn sẽ có cơ hội sở hữu một trợ lý AI mạnh mẽ hoạt động hoàn toàn ngoại tuyến, dễ tích hợp và tùy biến theo nhu cầu.

Bài viết liên quan: